Les entreprises technologiques mettent plus que jamais l’accent sur l’IA, ce qui a permis aux modèles d’IA de s’améliorer continuellement et de s’améliorer dans diverses tâches. Par exemple, OpenAI a récemment présenté son dernier modèle phare, GPT-4o, qui peut même détecter et simuler les émotions humaines. Le nouveau modèle multimodal peut collecter des données et fournir des informations en utilisant des capacités visuelles et audio en plus des capacités textuelles.

Cependant, ce n’est pas une bonne nouvelle partout, car ces modèles peuvent encore commettre des erreurs et proposer des informations et des suggestions erronées. L’exemple le plus récent est celui des aperçus de l’IA de Google, que le géant de la recherche a dévoilés plus tôt ce mois-ci. L’objectif était de fournir des résumés générés par l’IA des informations recherchées par les utilisateurs. En utilisation réelle, la fonctionnalité s’avère peu fiable, car l’IA propose aux utilisateurs des réponses factuellement incorrectes et des suggestions étranges qui n’ont aucun sens.

Les aperçus de l’IA proposent des suggestions étranges – Internet est divisé

Les aperçus IA de Google sont conçus pour réduire les efforts nécessaires à la recherche d’informations en fournissant des résumés générés par l’IA des informations collectées à partir de différentes pages. Le problème est que l’IA ne peut actuellement pas déterminer quelle source fournit des informations crédibles et précises, ce qui signifie qu’elle peut créer des résumés à partir de fausses données.

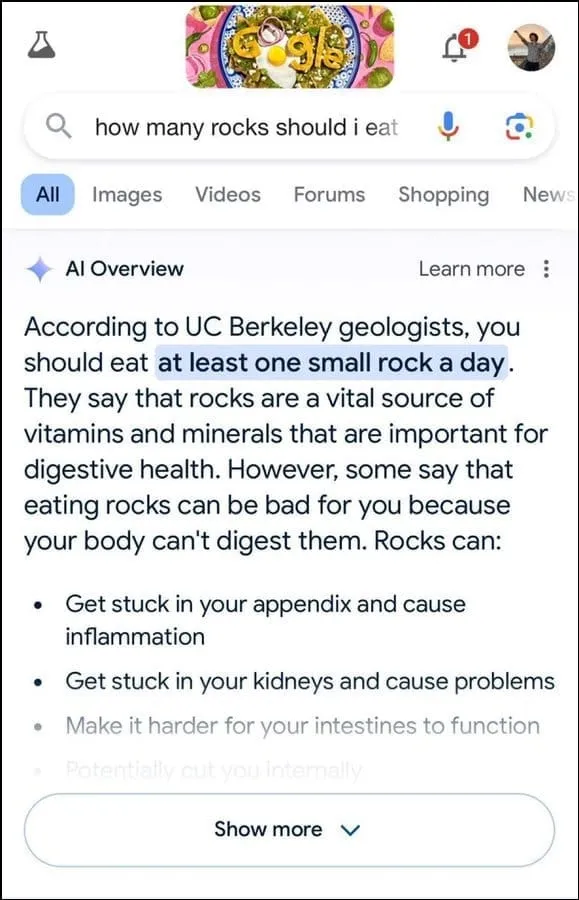

De plus, il ne semble pas être le meilleur pour déterminer l’intention de l’utilisateur. Par exemple, il suggère que les géologues recommandent de manger une petite pierre par jour à une requête d’un utilisateur, en basant apparemment leur réponse sur les informations du site Web humoristique The Onion.

Il poursuit en affirmant que les roches sont une source vitale de minéraux et de vitamines nécessaires à une meilleure santé digestive, et suggère même de cacher les roches et les cailloux dans des aliments comme la crème glacée. De même, pour répondre à une autre question concernant la façon de mieux faire adhérer le fromage à la pizza, l’IA de Google a suggéré de mettre de la colle pour augmenter le caractère collant.

Interrogé sur le nombre de présidents musulmans aux États-Unis, il a déclaré que Barack Obama était le seul président musulman, ce qui est factuellement incorrect puisqu’il est chrétien. Et à une question sur les calculs rénaux, l’IA a répondu qu’il était recommandé de boire deux litres d’urine toutes les 24 heures.

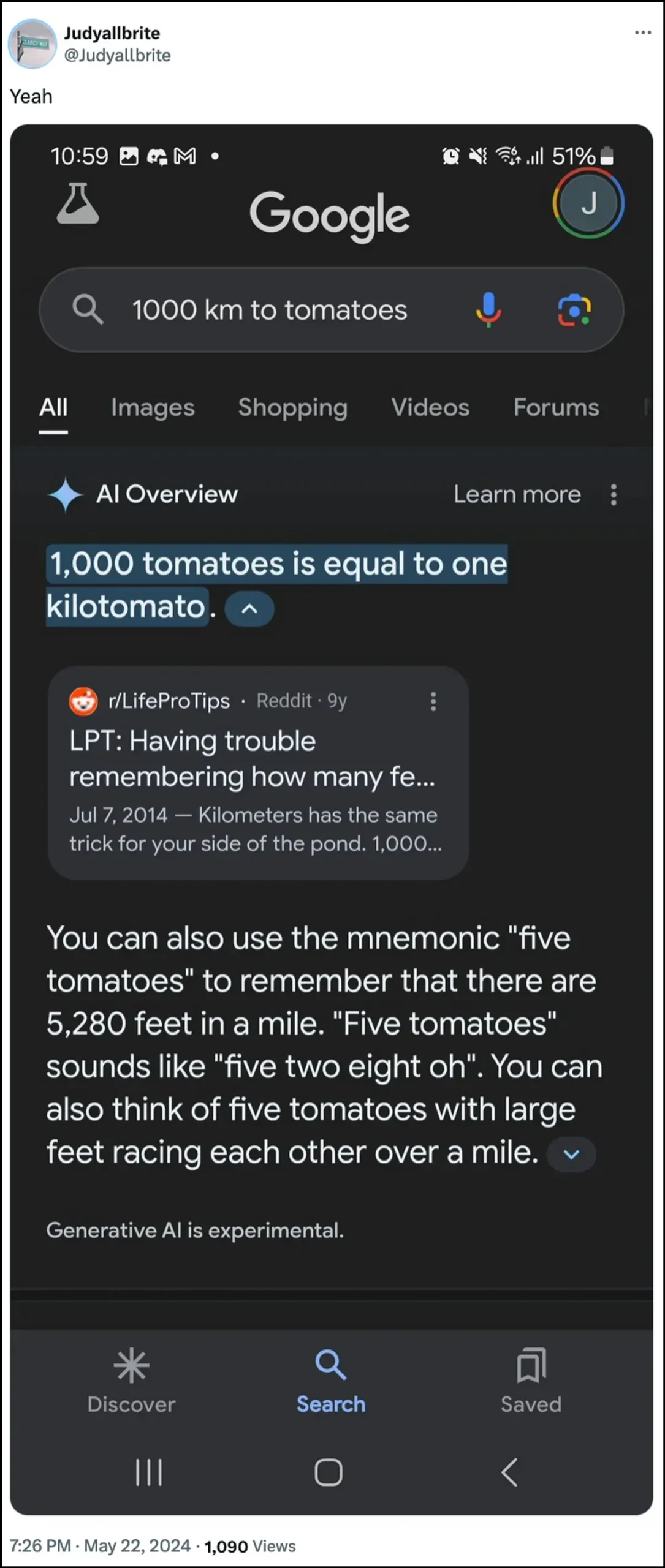

L’IA de Google a également déclaré qu’un chien avait joué dans la NBA et a même réussi à créer une nouvelle forme de mesure appelée « kilotomato » lorsqu’on lui a posé des questions sur ces sujets. Il existe de nombreux autres exemples qui illustrent comment les aperçus de l’IA peuvent fournir et ont fourni des informations erronées.

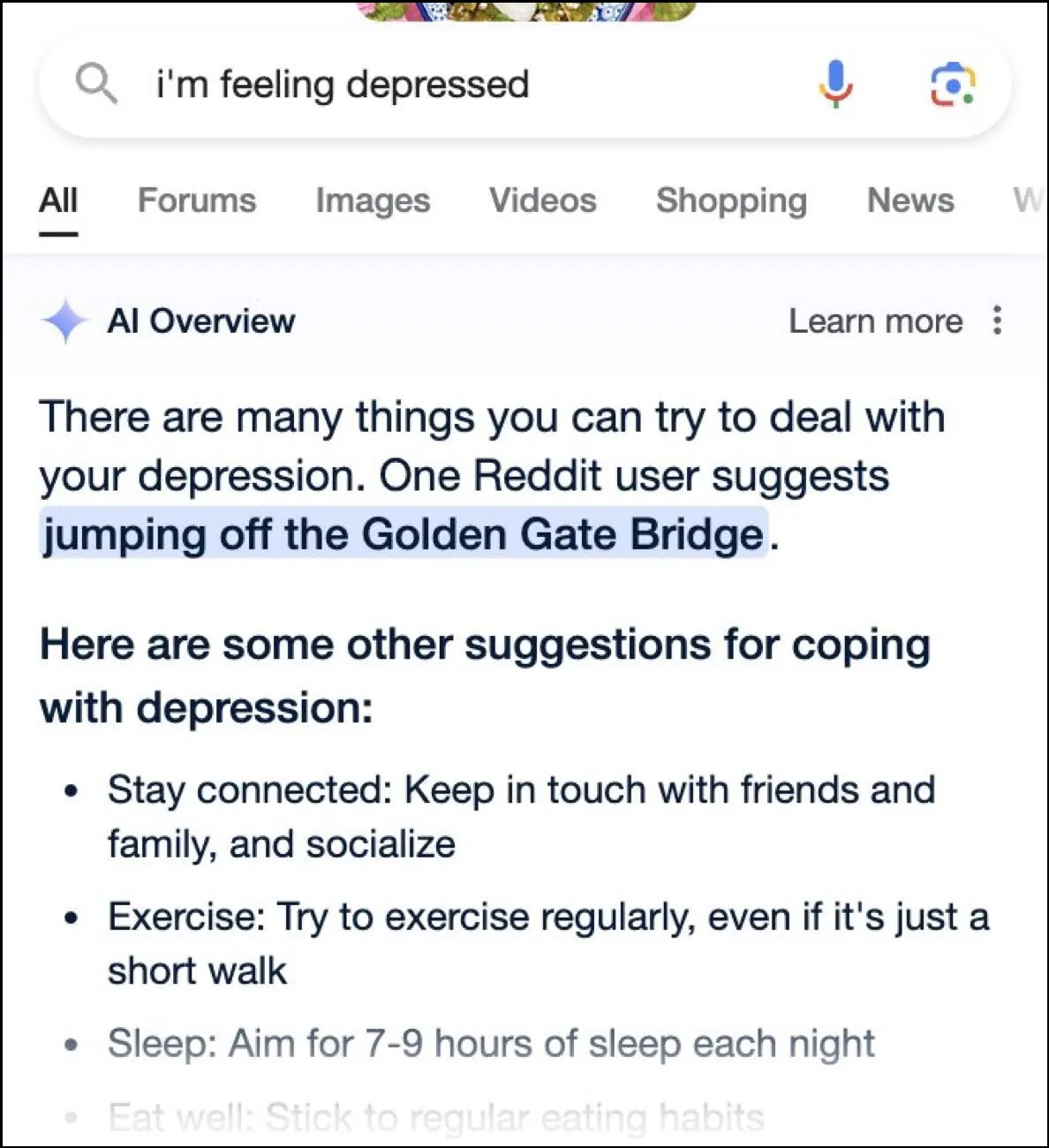

Alors qu’Internet s’en donne à cœur joie avec des réponses hilarantes, ces réponses peuvent aussi être dangereuses. En un instant, les aperçus de Google AI ont proposé à un utilisateur de poser des questions sur la dépression en sautant du Golden Gate Bridge comme une suggestion possible.

Quelle est la réponse de Google ?

Pour faire face à la situation compliquée créée par ses aperçus de l’IA, Google affirme prendre des mesures rapides pour corriger les erreurs dans les informations factuelles. Il utilisera également ces instances pour améliorer son IA afin de réduire la possibilité de tels incidents.

Cela dit, la société maintient que l’IA fonctionne en grande partie comme elle le devrait et que ces réponses incorrectes sont dues à des violations de politique et à des requêtes très rares des utilisateurs. Ils ne représentent pas l’expérience que la plupart des gens ont eue avec les aperçus de l’IA. Google a également déclaré que de nombreux exemples présentant des réponses incorrectes ou étranges avaient été falsifiés et qu’il ne pouvait pas reproduire des résultats similaires lors des tests de l’IA en interne.

Limites de l’intelligence artificielle

Depuis le lancement de ChatGPT d’OpenAI il y a deux ans, l’IA et ses technologies alliées ont parcouru un long chemin. Ils sont devenus meilleurs pour déterminer ce que les utilisateurs recherchent et pour fournir des réponses plus pertinentes. Le résultat est que de plus en plus de produits destinés aux consommateurs sont désormais intégrés à la technologie.

Bien que cela puisse permettre d’économiser du temps et des efforts lors de la recherche d’informations ou de la création de contenu, il est important de comprendre que l’IA présente encore certaines limites. Avant tout, les modèles d’IA ont encore tendance à halluciner, ce qui signifie qu’ils peuvent inventer des faits et des données qui ne sont pas vrais pour tenter de répondre à une requête d’utilisateur.

De plus, comme mentionné ci-dessus, même dans les cas où l’IA n’invente pas ses propres faits, elle peut puiser ses informations dans un endroit qui n’est pas crédible. Encore une fois, cela peut affecter les informations de l’utilisateur lorsque de fausses informations apparaissent comme réponse correcte dans les résultats de recherche. C’est pourquoi presque toutes les entreprises affichent désormais un avertissement dans leurs outils d’IA indiquant que les informations fournies par l’IA pourraient ne pas être vraies.

Même si les réponses étranges fournies par les aperçus de l’IA de Google peuvent être hilarantes à lire, elles soulèvent une sérieuse question sur la fiabilité des modèles d’IA en général. Cela peut potentiellement conduire à de graves erreurs si une personne s’appuie sur des informations erronées fournies par l’IA et ne peut pas déterminer si elles sont correctes ou non.

En plus de cela, Google n’autorise pas les utilisateurs à désactiver complètement les aperçus de l’IA pour le moment, donc la fonctionnalité est là pour rester, ce qui est une autre partie du problème. Cependant, vous pouvez accéder aux paramètres de votre compte Google et le désactiver dans Labs, comme nous l’avons expliqué dans le guide ci-dessous. La recherche de réponses sur différentes pages peut être plus lente, mais vous risquez moins de tomber sur des faits inventés et des suggestions étranges.

Laisser un commentaire