Un autre modèle d’IA a rejoint la mer des modèles d’IA et celui-ci provient encore d’OpenAI. OpenAI a déjà publié GPT-4o cette année, qui était censé être plus efficace que GPT-4. Mais il était encore assez cher et pouvait représenter une facture assez élevée, en particulier pour les développeurs qui ont besoin d’appeler le modèle d’IA via l’API de leurs applications à plusieurs reprises tout au long de la journée.

En conséquence, les développeurs se sont tournés vers des modèles d’IA plus petits et moins chers proposés par des concurrents, comme Gemini 1.5 Flash ou Claude 3 Haiku.

OpenAI lance désormais le GPT-4o mini, son modèle le plus économique à ce jour, avec lequel il entre également dans le domaine des petits modèles d’IA. Bien que le GPT-4o mini soit leur modèle le moins cher à ce jour, il n’atteint pas ce faible coût en réduisant l’intelligence ; il est plus intelligent que leur modèle GPT-3.5 Turbo existant.

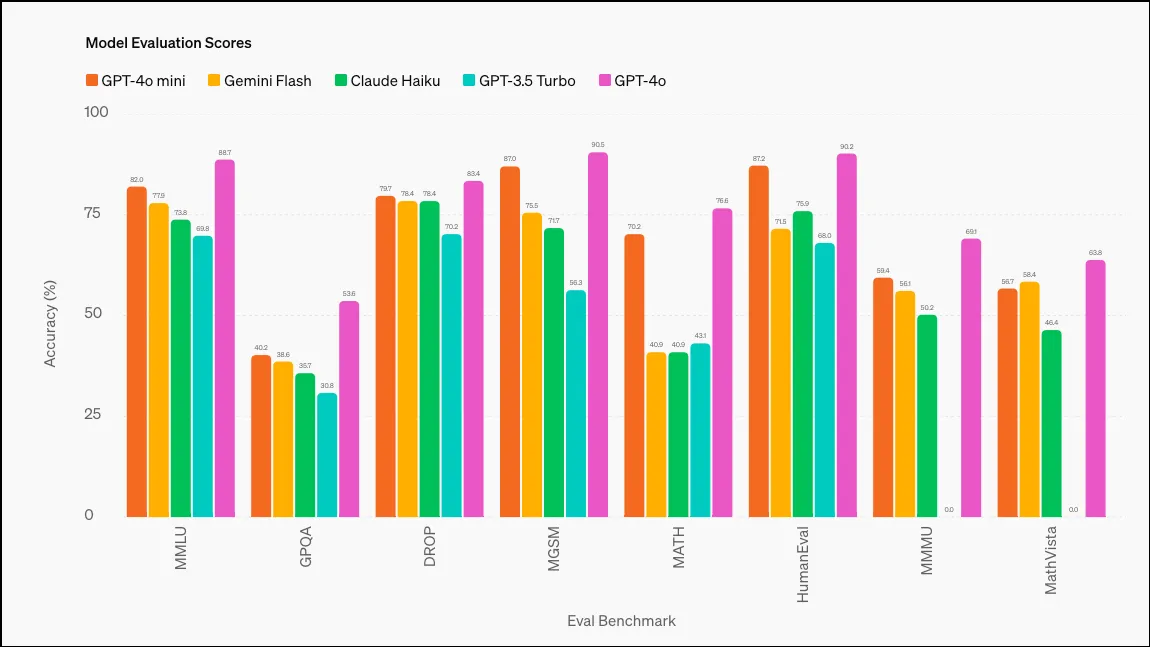

Selon OpenAI, GPT-4o mini a obtenu un score de 82 % dans le MMLU (Measuring Massive Multitask Language Understanding), surpassant de nombreux modèles ; voici les scores respectifs de différents modèles : GPT-3.5 Turbo (70 %), Claude 3 Haiku (75,2 %) et Gemini 1.5 Flash (78,9 %). GPT-4o a obtenu un score de 88,7 % sur ce benchmark, Gemini Ultra affichant le score le plus élevé – 90 % (ce ne sont cependant pas de petits modèles d’IA).

GPT-4o mini est en cours de déploiement pour les utilisateurs de ChatGPT Free, Team et Plus ainsi que pour les développeurs aujourd’hui. Pour les utilisateurs de ChatGPT, il a essentiellement remplacé GPT-3.5 ; GPT-4o mini sera le modèle par défaut de la conversation une fois que vous n’aurez plus de requêtes GPT-4o gratuites. Les développeurs auront toujours la possibilité d’utiliser GPT-3.5 via l’API, mais il sera finalement abandonné. Les utilisateurs de ChatGPT Enterprise auront accès à GPT-4o mini la semaine prochaine.

Comme mentionné ci-dessus, l’objectif de GPT-4o mini est d’aider les développeurs à trouver un modèle à faible coût et à faible latence pour leur application, qui soit également performant. Par rapport à d’autres petits modèles, GPT-4o mini excelle dans les tâches de raisonnement en texte et en vision, les tâches de raisonnement mathématique et de codage, ainsi que le raisonnement multimodal.

Il prend actuellement en charge à la fois le texte et la vision dans l’API, avec la prise en charge des entrées et sorties de texte, d’image, de vidéo et d’audio sur la feuille de route pour l’avenir.

GPT-4o mini dispose d’une fenêtre contextuelle de 128 000 jetons pour l’entrée et de 16 000 jetons pour la sortie par requête, avec ses connaissances allant jusqu’en octobre 2023. Il peut également gérer du texte non anglais de manière assez rentable.

Laisser un commentaire