Si vous souhaitez exécuter des modèles linguistiques volumineux ou des LLM sur votre ordinateur, l’un des moyens les plus simples de le faire est d’utiliser Ollama. Ollama est une puissante plateforme open source qui offre une expérience d’IA personnalisable et facilement accessible. Elle permet de télécharger, d’installer et d’interagir facilement avec divers LLM, sans avoir besoin de s’appuyer sur des plateformes basées sur le cloud ou de nécessiter une quelconque expertise technique.

En plus des avantages mentionnés ci-dessus, Ollama est assez léger et est régulièrement mis à jour, ce qui le rend tout à fait adapté à la création et à la gestion de LLM sur des machines locales. Ainsi, vous n’avez pas besoin de serveurs externes ni de configurations compliquées. Ollama prend également en charge plusieurs systèmes d’exploitation, notamment Windows, Linux et macOS, ainsi que divers environnements Docker.

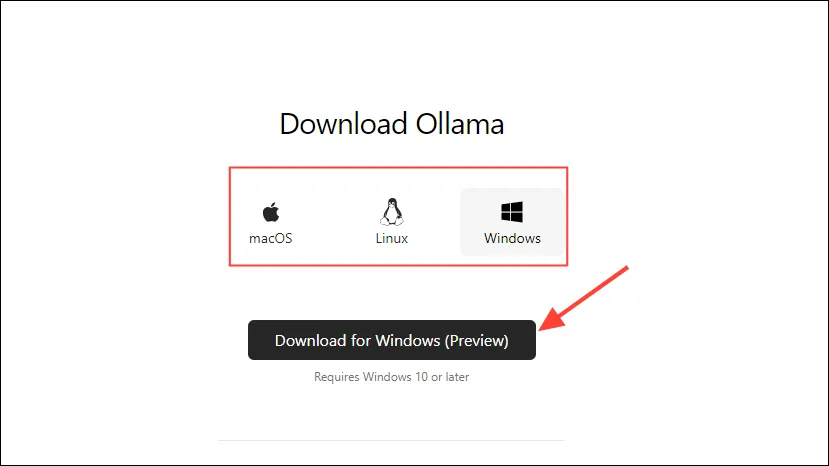

Téléchargement et installation d’Ollama

- Tout d’abord, visitez la page de téléchargement d’Ollama et sélectionnez votre système d’exploitation avant de cliquer sur le bouton « Télécharger ».

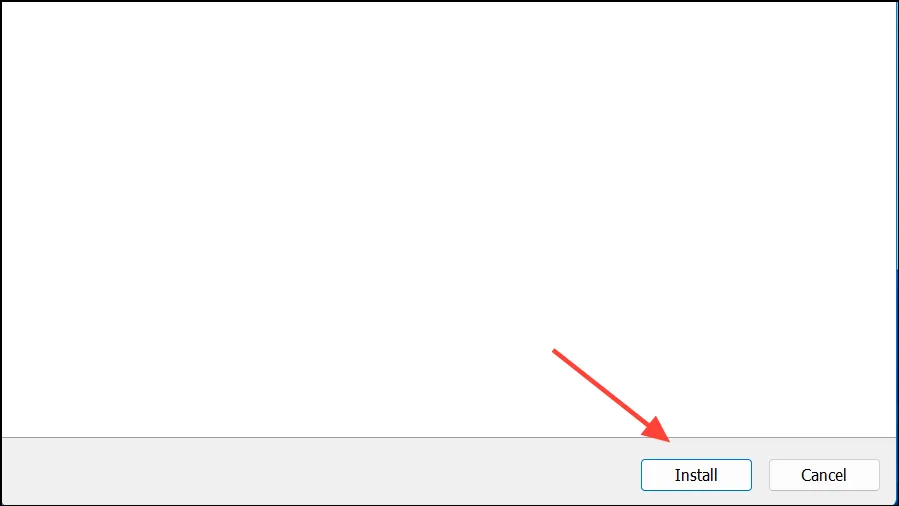

- Une fois le téléchargement terminé, ouvrez-le et installez-le sur votre machine. Le programme d’installation se fermera automatiquement une fois l’installation terminée.

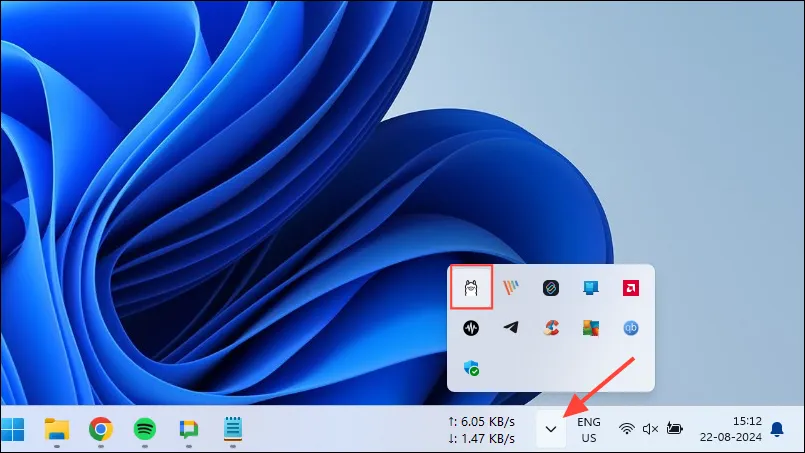

- Sous Windows, vous pouvez vérifier si Ollama est en cours d’exécution ou non en cliquant sur le bouton de débordement de la barre des tâches pour afficher les icônes cachées.

Personnaliser et utiliser Ollama

Une fois Ollama installé sur votre ordinateur, la première chose à faire est de modifier l’emplacement de stockage de vos données. Par défaut, l’emplacement de stockage est , C:\Users\%username%\.ollama\modelsmais comme les modèles d’IA peuvent être assez volumineux, votre lecteur C peut se remplir rapidement. Pour ce faire,

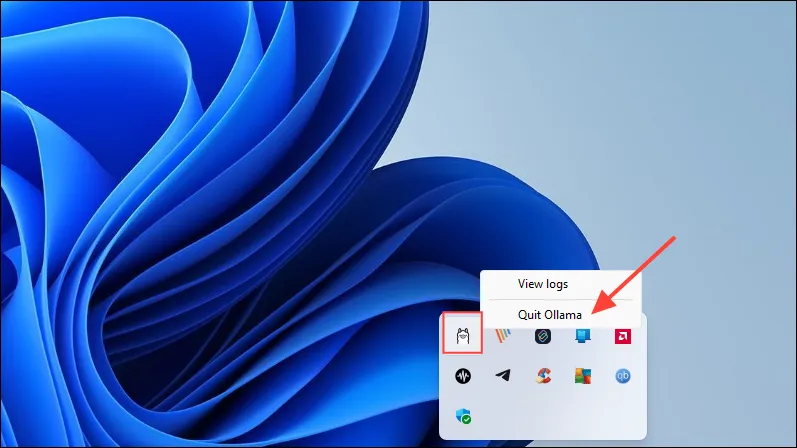

- Tout d’abord, cliquez sur l’icône Ollama dans la barre des tâches et cliquez sur « Quitter Ollama ».

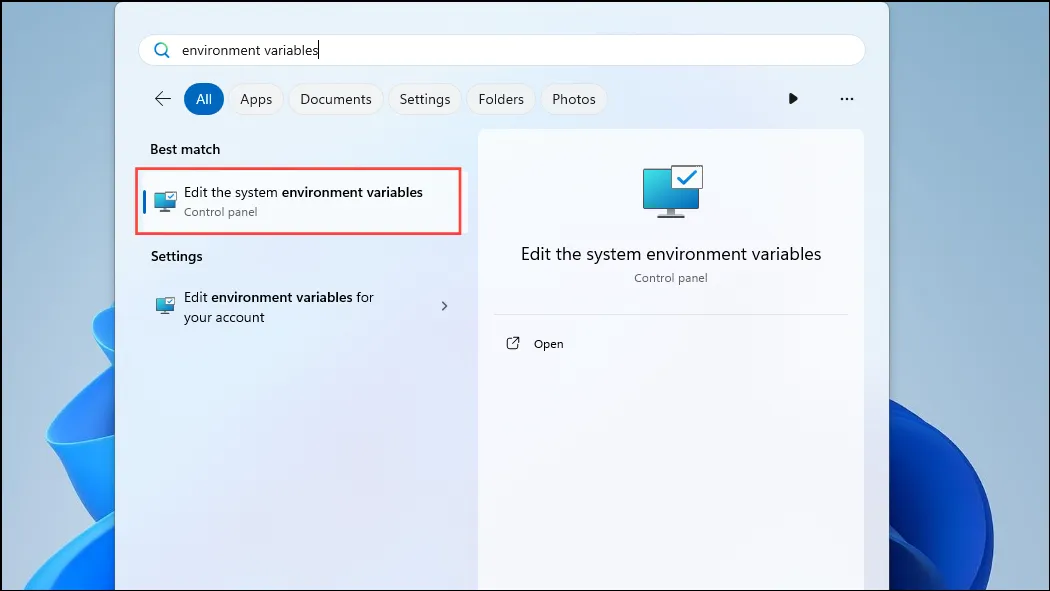

- Une fois Ollama sorti, ouvrez le menu Démarrer, tapez

environment variableset cliquez sur « Modifier les variables d’environnement système ».

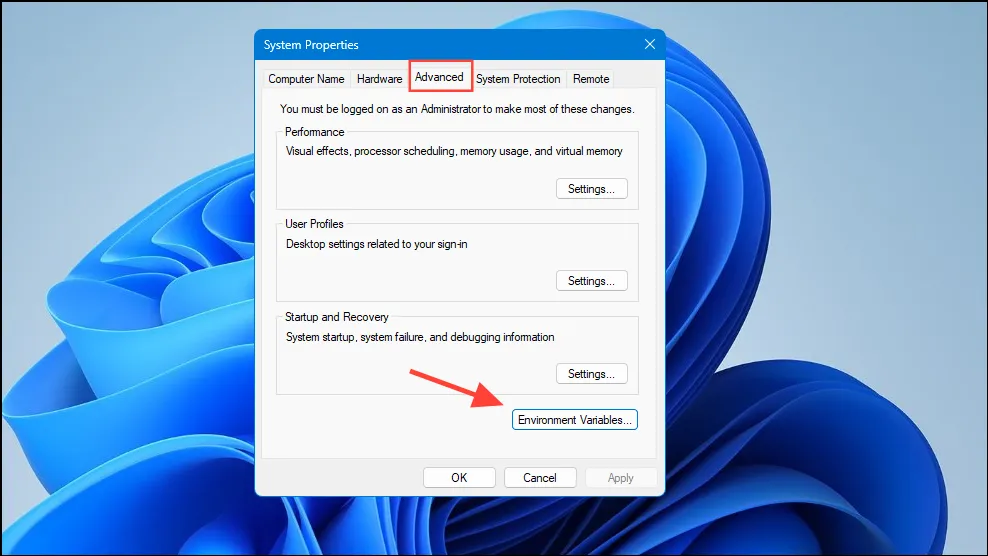

- Lorsque la boîte de dialogue Variables système s’ouvre, cliquez sur le bouton « Variables d’environnement » dans l’onglet « Avancé ».

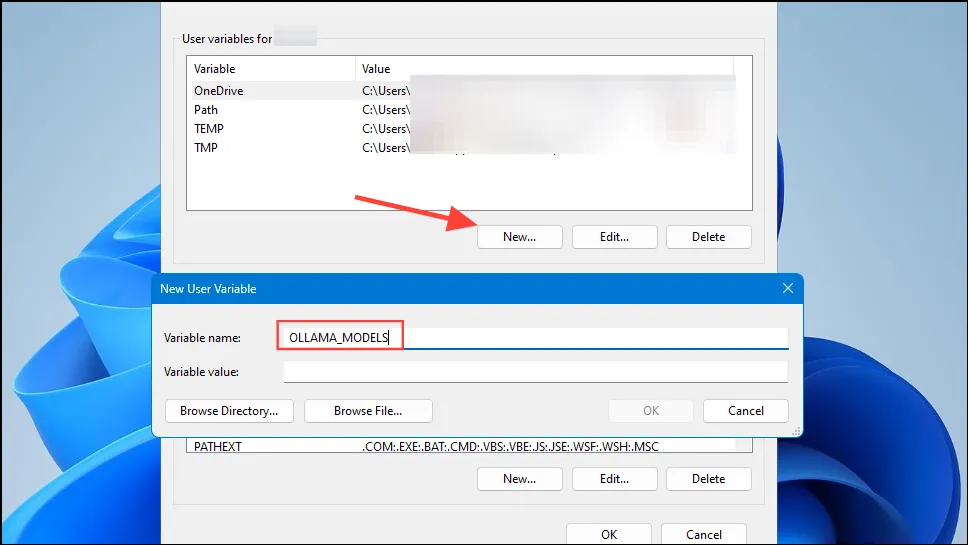

- Cliquez sur le bouton « Nouveau » pour votre compte utilisateur et créez une variable nommée

OLLAMA_MODELSdans le champ « Nom de la variable ».

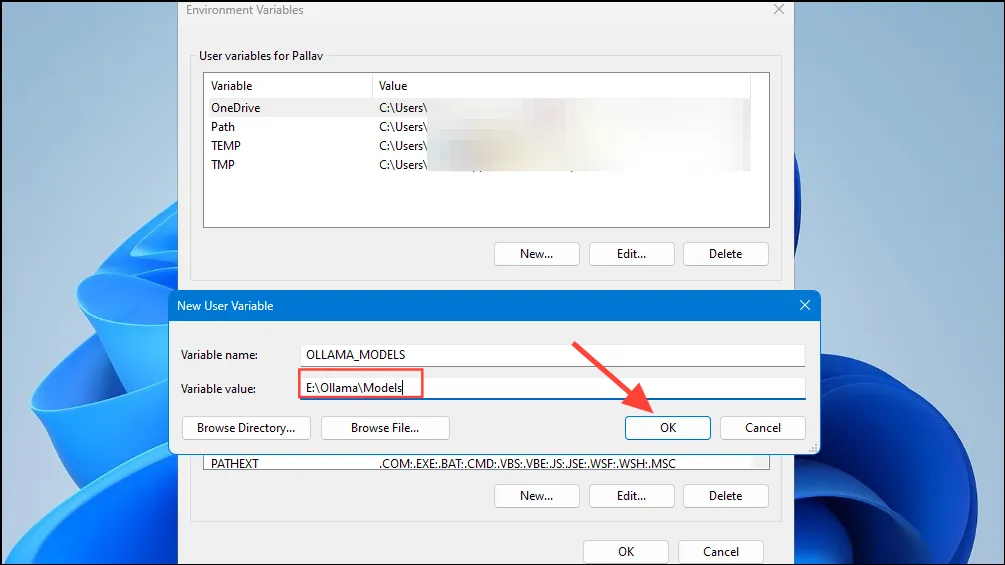

- Tapez ensuite l’emplacement du répertoire où vous souhaitez qu’Ollama stocke ses modèles dans le champ « Valeur de la variable ». Cliquez ensuite sur le bouton « OK » avant de lancer Ollama depuis le menu Démarrer.

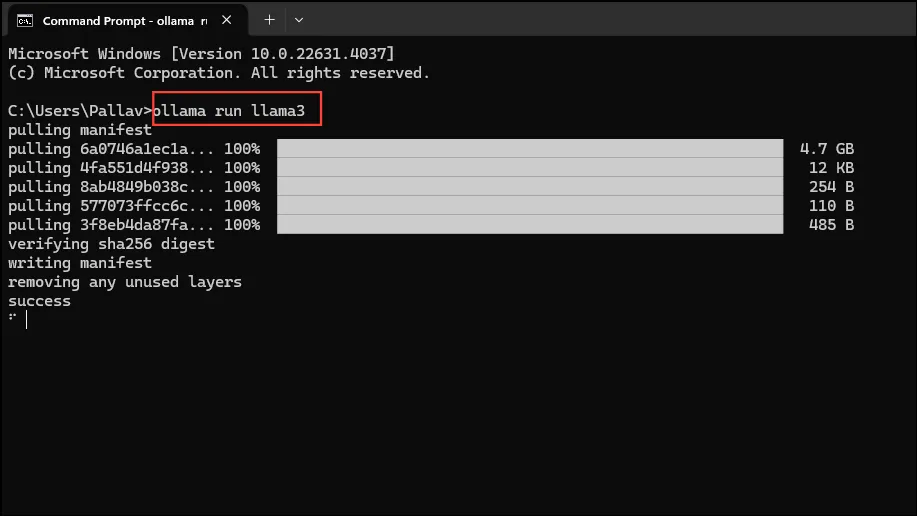

- Vous êtes maintenant prêt à commencer à utiliser Ollama, et vous pouvez le faire avec Llama 3 8B de Meta, le dernier modèle d’IA open source de la société. Pour exécuter le modèle, lancez une invite de commande, Powershell ou une fenêtre de terminal Windows à partir du menu Démarrer.

- Une fois la fenêtre d’invite de commande ouverte, tapez

ollama run llama3et appuyez sur Entrée. Le modèle fait près de 5 Go, son téléchargement prendra donc du temps.

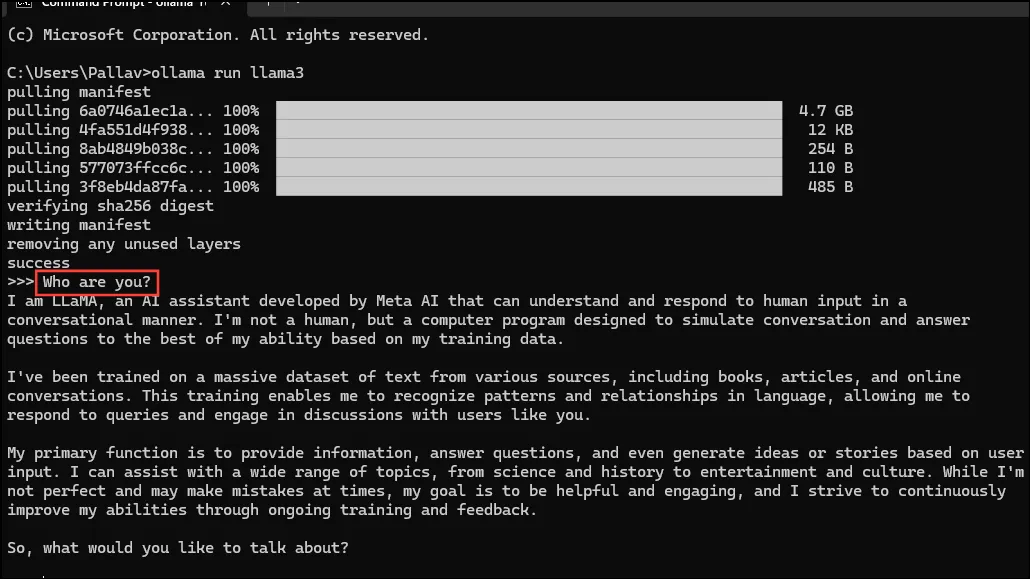

- Une fois le téléchargement terminé, vous pouvez commencer à utiliser Llama 3 8B et converser avec lui directement dans la fenêtre de ligne de commande. Par exemple, vous pouvez demander au modèle

Who are you?et appuyer sur Entrée pour obtenir une réponse.

- Vous pouvez désormais poursuivre la conversation et poser des questions aux modèles d’IA sur divers sujets. Gardez simplement à l’esprit que Llama 3 peut faire des erreurs et avoir des hallucinations, vous devez donc être prudent lorsque vous l’utilisez.

- Vous pouvez également tester d’autres modèles en visitant la page de la bibliothèque de modèles Ollama. De plus, il existe différentes commandes que vous pouvez exécuter pour tester différentes fonctionnalités proposées par Ollama.

- Vous pouvez également effectuer diverses opérations lors de l’exécution d’un modèle, telles que la définition de variables de session, l’affichage des informations du modèle, l’enregistrement d’une session, etc.

- Ollama permet également de tirer parti des modèles d’IA multimodaux pour reconnaître des images. Par exemple, le modèle LLava peut reconnaître les images générées par DALLE-3. Il peut décrire les images en détail.

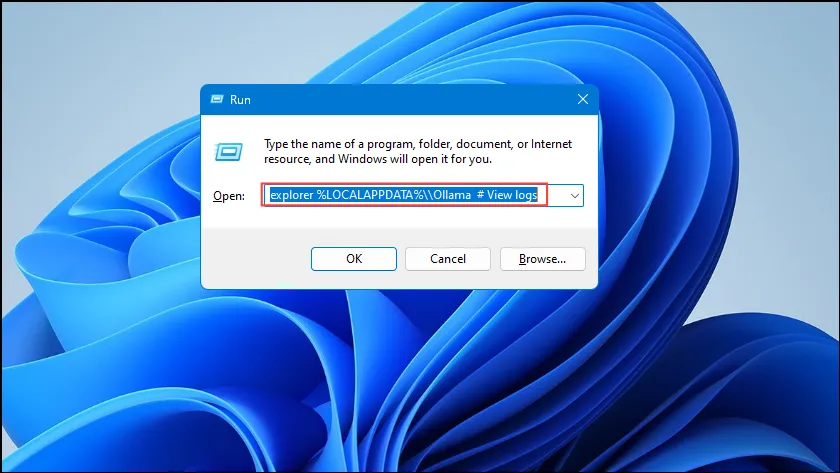

- Si vous rencontrez des erreurs lors de l’exécution d’Ollama, vous pouvez consulter les journaux pour déterminer quel est le problème. Utilisez le

Win + Rraccourci pour ouvrir la boîte de dialogue Exécuter, puis saisissez votreexplorer %LOCALAPPDATA%\\Ollama # View logstexte avant d’appuyer sur Entrée.

- Vous pouvez également utiliser d’autres commandes telles que

explorer %LOCALAPPDATA%\\Programs\\Ollamaetexplorer %HOMEPATH%\\.ollamapour vérifier les binaires, le modèle et l’emplacement de stockage de la configuration.

Choses à savoir

- Ollama détecte automatiquement votre GPU pour exécuter des modèles d’IA, mais sur les machines équipées de plusieurs GPU, il peut sélectionner le mauvais. Pour éviter cela, ouvrez le panneau de configuration Nvidia et définissez l’affichage sur « GPU Nvidia uniquement ».

- Le mode d’affichage peut ne pas être disponible sur toutes les machines et est également absent lorsque vous connectez votre ordinateur à des écrans externes.

- Sous Windows, vous pouvez vérifier si Ollama utilise le bon GPU à l’aide du Gestionnaire des tâches, qui affichera l’utilisation du GPU et vous indiquera lequel est utilisé.

- Bien que l’installation d’Ollama sur macOS et Linux soit un peu différente de celle de Windows, le processus d’exécution de LLM via celui-ci est assez similaire.

Laisser un commentaire