OpenAI a récemment annoncé son modèle GPT-4o, un nouveau modèle phare du moteur qui alimente ChatGPT, son célèbre chatbot alimenté par l’IA lancé pour la première fois en 2022. Ce modèle plus récent porte l’interaction homme-machine à un tout nouveau niveau en la faisant paraître plus rapide et plus rapide. beaucoup plus naturel.

Dans GPT-4o, le « o » signifie « omni », car il combine le texte, l’image et l’audio en un seul modèle. Bien qu’il n’y ait aucune amélioration en termes d’intelligence et de raisonnement par rapport au modèle GPT-4 Turbo, de nombreuses nouvelles mises à jour sont disponibles. Il est conçu pour fournir des réponses plus rapides et plus humaines, et peut même simuler des émotions. Il est également beaucoup plus rapide à comprendre les entrées visuelles et audio. Dans cette étude approfondie, nous examinerons les fonctionnalités offertes par GPT-4o et comment elles révolutionneront la façon dont nous interagissons avec les assistants IA. Alors rejoignez-nous et commençons !

GPT-4o est nettement plus rapide

Le modèle GPT-4o permet à ChatGPT d’accepter des entrées sous diverses formes, notamment de l’audio, du texte, des images ou leurs combinaisons. Il peut également fournir des réponses sous différents formats. Ce qui est le plus impressionnant, cependant, c’est la rapidité avec laquelle il vous fournit des réponses.

Avec le nouveau modèle, ChatGPT ne prend qu’environ 320 millisecondes, voire moins, pour répondre aux entrées audio, ce qui est proche du temps qu’il faut à une personne pour répondre dans une conversation. En plus de cela, les performances de GPT-4o sont similaires à celles de GPT-4 Turbo en ce qui concerne l’utilisation de l’anglais ou l’écriture de code.

Il répond également beaucoup mieux à des saisies de texte dans des langues autres que l’anglais et est considérablement moins cher dans l’API car il est beaucoup plus efficace que son prédécesseur.

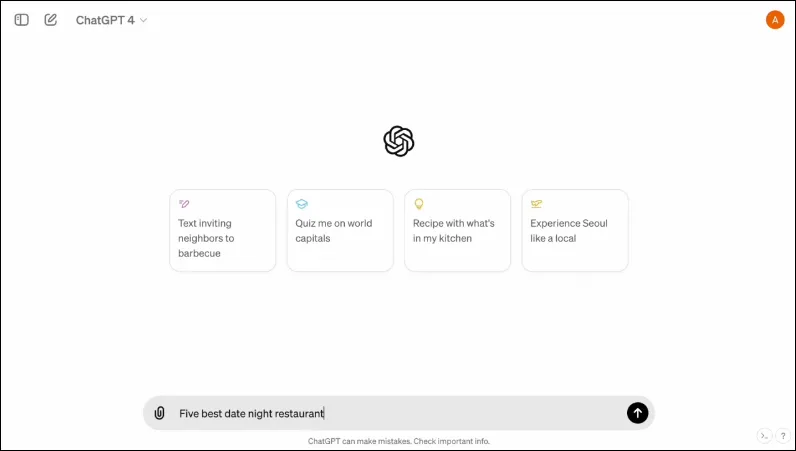

Il dispose également d’une nouvelle interface, conçue pour rendre l’interaction plus facile et plus soignée.

C’est multimodal

Le mode vocal existant de ChatGPT se compose de trois modèles. Le premier prend en compte les entrées textuelles et fournit une sortie dans le même format, tandis que le second convertit les entrées audio en texte, qui est pris en charge par ChatGPT pour fournir une sortie textuelle. Le dernier modèle convertit le texte en audio.

Cependant, cette conception entraîne une perte d’informations puisque le modèle ne peut pas interagir directement avec l’entrée audio ni présenter une sortie contenant des éléments émotionnels. Avec GPT-4o, OpenAI a construit un modèle multimodal unique capable de comprendre différents types d’entrées et de traiter directement la sortie requise.

Il prend actuellement en charge 50 langues et sera également disponible sous forme d’API.

Il peut simuler les émotions humaines

Lorsque ChatGPT a été annoncé pour la première fois, l’un des plus gros inconvénients du chatbot IA pour de nombreuses personnes était qu’il ne pouvait pas fournir de réponses émotionnelles. Avec GPT-4o, ChatGPT peut simuler les émotions humaines et fournir des réponses adaptées intégrant ces émotions.

Dans les démos partagées par OpenAI, on peut voir le chatbot rire, chanter et même faire preuve de sarcasme lorsqu’on le lui demande. C’est bien au-dessus de ce que n’importe quel autre chatbot IA peut faire actuellement et rendra les interactions avec les utilisateurs beaucoup plus agréables. Selon OpenAI, le nouveau modèle permettra à ChatGPT de détecter également l’humeur des utilisateurs et de fournir des réponses adéquates basées sur ces informations.

Combinée à la capacité d’utiliser des entrées visuelles, la capacité à fournir des réponses émotionnelles est l’une des fonctionnalités les plus impressionnantes offertes par le nouveau modèle.

Le nouveau modèle peut stocker une plus grande quantité d’informations

Grâce à GPT-4o, ChatGPT peut désormais mieux comprendre les images, telles que les graphiques et les photos, et également stocker plus d’informations sur l’utilisateur. Cela se traduit également par des réponses pouvant contenir des morceaux de texte plus volumineux, ce qui peut s’avérer utile dans plusieurs cas d’utilisation.

Par exemple, vous pouvez demander au chatbot de traduire des morceaux de texte plus volumineux maintenant et il peut vous aider avec la traduction en direct. Puisqu’il peut utiliser des entrées visuelles et audio ainsi que des entrées textuelles, vous pouvez l’utiliser pour collecter des informations à partir de captures d’écran, de photos et d’autres images.

Puisqu’il peut stocker une plus grande quantité d’informations sans que les utilisateurs aient besoin de réitérer, GPT-4o permet aux utilisateurs de participer à des conversations aller-retour avec le chatbot IA. Avec davantage d’informations, les utilisateurs peuvent s’attendre à ce que les conversations soient plus sophistiquées.

Garanties dans le nouveau modèle

Comme les modèles GPT existants, le GPT-4o est conçu avec certaines garanties à l’esprit pour garantir la sécurité. Les données d’entraînement ont été filtrées et le comportement du modèle a été affiné après l’entraînement. OpenAI a également évalué le modèle d’IA sur plusieurs paramètres, tels que la cybersécurité et la persuasion, pour éviter les incidents indésirables.

En outre, les développeurs ont fait appel à plus de 70 experts dans divers domaines tels que la désinformation et la psychologie sociale pour identifier et atténuer les risques qui pourraient survenir ou augmenter avec le nouveau modèle. Ils continueront également à surveiller l’utilisation du chatbot pour détecter les risques futurs et prendront les mesures nécessaires si nécessaire.

Pour commencer, OpenAI ne mettra à disposition qu’une sélection limitée de préréglages de modèles vocaux. Il prendra également en compte les retours fournis par les utilisateurs pour améliorer le modèle et garantir une sécurité totale.

Disponibilité du GPT-4o

Jusqu’à présent, deux versions de ChatGPT étaient disponibles : une version gratuite fonctionnant sur GPT 3.5 et une version payante fonctionnant sur GPT 4.0 et coûtant 20 $ par mois. Ce dernier peut accéder à un modèle de langage plus large lui permettant de gérer de plus grandes quantités de données.

GPT-4o sera disponible pour les utilisateurs gratuits et payants et devrait être déployé sur les appareils dans les semaines à venir. Elle sera disponible sur les appareils mobiles via l’application existante, qui sera mise à jour, et une nouvelle application de bureau macOS sera également disponible en plus de la version Web pour les utilisateurs de bureau (la version Windows arrivera plus tard cette année).

Pour distinguer les utilisateurs gratuits et payants, OpenAI offrira aux utilisateurs payants cinq fois plus de capacité que celle qui sera offerte aux utilisateurs gratuits. Une fois que vous aurez dépassé votre limite, vous reviendrez à ChatGPT 3.5.

L’annonce d’OpenAI concernant GPT-40 intervient juste un jour avant la conférence annuelle des développeurs I/O de Google, où Google devrait faire ses propres annonces liées à l’IA. OpenAI a également promis que d’autres annonces seraient en cours, il ne fait donc aucun doute que la concurrence entre les deux rivaux commence tout juste à s’intensifier.

Bien que nous ne sachions pas quand OpenAI dévoilera d’autres modifications de son modèle d’IA, nous savons que GPT-4o se dirige vers les appareils exécutant ChatGPT dans le monde entier. Alors croisez les doigts et attendez que la mise à jour apparaisse sur votre appareil. Jusqu’à la prochaine fois!

Laisser un commentaire